以前は、より柔軟なAI応答のためにBypassGPTに頼っていましたが、今はもう利用できず、作業フローに支障が出ています。ルール違反やアカウント停止のリスクなしで、これに近い検閲なし、または制限が少ないAIの挙動を提供してくれる、安全で無料の代替ツールはありますか?おすすめのサービスに加えて、導入時のコツや、セキュリティやプライバシー面で注意すべき点も教えてもらえると助かります。

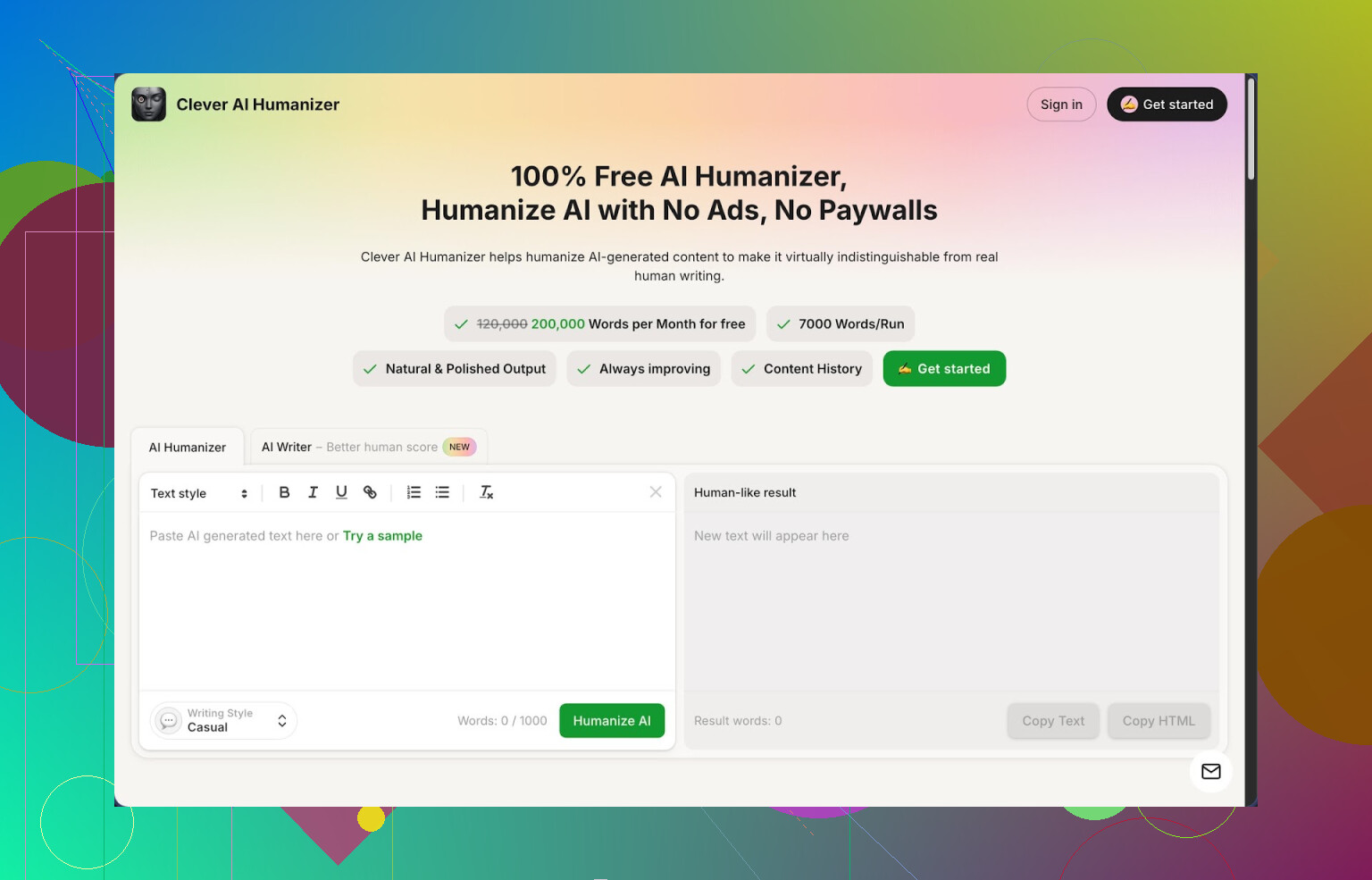

1. Clever AI Humanizer – 長時間使い倒してみた正直な感想

Clever AI Humanizer は、AIテキストの「いかにもAIっぽい感じ」を消したいときに、結局いつも戻ってくるツールです。完璧だからではなく、無料枠の上限がかなりゆるくて、数分おきに「課金して」とうるさく言ってこないからです。

自分の使用感ベースのざっくりした数字:

- 無料プランで月あたり約20万ワードまで

- 1回の実行で最大約7,000ワード

- スタイルは3種類:カジュアル、ライト学術、ライトフォーマル

- AIライター、文法チェッカー、パラフレーズ機能を内蔵

最初に見つけたのは、長文をZeroGPTに引っかからないようにしたかったときです。モデルの出力そのままを数千ワード貼り付けて、カジュアルモードで回したところ、ZeroGPTで3つのサンプルすべてがAI判定0%になりました。多くのツールは意味が崩れたり、それでも「AIっぽい」と判定されたりするので、これはかなり目を引きました。

AIツールで文章を書くときの一番の悩みはおなじみだと思います。トーンが平板で、同じ表現が繰り返され、検出ツールには100%機械判定されること。週末に「ヒューマナイザー」系を何種類も試しましたが、最終的にタブを開きっぱなしにしたのはこれだけでした。

ここからは、メインのモジュールがどう動くか、自分なりの見え方です。

AIで生成したテキストを貼り付けて、スタイルを選び(自分はほぼカジュアル固定)、ボタンを押して数秒待つだけです。返ってくるのは、よくあるAIっぽいパターンを崩しつつ、部分的に長くしたり短くしたり、言い回しをずらして、検出ツールから見ても自然な文章に寄せたバージョンです。1回あたりの上限が大きいので、長い記事やレポートを扱うときにかなり助かります。細切れにすると流れが壊れがちなので。

意外だったのは、意味がだいたいそのまま保たれることでした。技術系の解説、意見記事、ややアカデミック寄りのセクションなどで試しましたが、多くのケースで、主張やデータの軸は変えずに、構成やリズムだけが変わって「人が午後にカタカタ打った感じ」に近づいていました。

ここからは、日常的に便利だと感じた追加モジュールについて。

Free AI Writer は、サイト上でそのまま下書きを生成できる機能です。記事やエッセイのお題を投げるとベースの原稿を書いてくれるので、それをそのままヒューマナイザーに流す、というワンセットの使い方ができます。検出ツールのスコアという意味では、この組み合わせが一番よかったです。生のAI下書きはZeroGPTで「かなりAIっぽい」と出ることが多いのですが、ヒューマナイズ後は、自分のテストでは0%まで落ちました。

Free Grammar Checker はシンプルですが、地味に便利です。二重スペース、余計なカンマ、変な語順などを直してくれます。Grammarly のような強力さはありませんが、ブログやメールにすぐ出せるレベルには十分整えてくれます。

Free AI Paraphraser は、どちらかというと一般的なリライターに近いです。自分はこんな用途で使いました:

- 既存記事の段落を書き換えて別バージョンにする

- SEOのテスト用に、文章のバリエーションを増やす

- 堅いトーンをくだけた感じに変える、またはその逆にする

これらが1つの画面で完結するので、自分のワークフローはだいたいこんな感じです:

- AI Writer で下書きを作る、または別モデルの出力を貼り付ける

- カジュアルスタイルで Humanizer にかける

- Grammar Checker でざっと整える

- 必要なら、特定の部分だけ Paraphraser で微調整

このセットのおかげで、テスト用に記事のバリエーションがたくさん必要なときや、「AIっぽい文体が嫌い」というクライアント向けに、急いで「脱AI化」したいときにかなり時間を節約できました。

使っていて感じたマイナス面もいくつかあります:

- どんな検出ツールでも毎回0%になるわけではありません。自分のテストでは ZeroGPT との相性はよかった一方、ほかの検出ツールでは、一部が「AI混在」や「一部AI」と出ることもありました。

- ヒューマナイズ後に文章が長くなりがちです。パターンを崩すためにフレーズを足したり広げたりするので、厳密な文字数制限がある場合は、自分で削る必要があります。

- ときどき不自然な言い回しが紛れ込むことがあります。特に専門的・ニッチな分野の文章では顕著なので、最終的に軽く読み直すようにしています。

それでも、月20万ワードまで使える無料ツールとしては、実際に使ってきた中で一番実用的でした。途中で急に課金画面が出てバッチ処理が止まることもなく、上限に達するまでかなり自由に試せます。

もっと詳しい説明やスクリーンショットを見たい場合は、こちらに長めのレビューがあります:

https://cleverhumanizer.ai/jp/community/t/clever-ai-humanizer-review-with-ai-detection-proof/42

動画で、実際の画面操作を見ながら知りたい人はこちら:

Clever AI Humanizer Youtube レビュー https://www.youtube.com/watch?v=G0ivTfXt_-Y

Reddit では、AIヒューマナイザー全般についての議論や、ほかの人のテスト結果もいくつか上がっています:

Reddit のおすすめAIヒューマナイザーまとめ https://www.reddit.com/r/DataRecoveryHelp/comments/1oqwdib/best_ai_humanizer/?tl=ja

AIテキストの「人間らしさ」を高める方法いろいろ https://www.reddit.com/r/DataRecoveryHelp/comments/1l7aj60/humanize_ai?tl=ja/

短いまとめ版。トレードオフなしで、本当に「検閲なし」の BypassGPT レベルの挙動を安全かつ無料で実現できるツールはありませんが、複数のモデルとヒューマナイザーを組み合わせれば、柔軟性の面ではかなり近づけます。

自分にとって一番うまくいったやり方は次のとおりです。

- 「バイパス」ラッパーよりも、もともと緩めのモデルを使う

魔法のツールではありませんが、多くのチャットボットより安全フィルターが弱めです。

・OpenRouter

1つのサイトやキーで複数モデルを叩けます。一部のモデルは、一般的なフロントエンドより自由度高めに応答します。温度やシステムプロンプトを自分で制御できるので、ブレインストーミング、小説、刺激的な内容などで「制限がゆるい」挙動を引き出しやすくなります。

欠点。公開モデルはリクエストをログに残すので、機密情報は送らないこと。

・Ollama や LM Studio でのローカルモデル

自分の PC 上でモデルを動かします。リモートのフィルターはかかりません。

無料で始めやすい候補:

- Llama 3 8B Instruct

- Qwen 2.5 7B / 14B

- Mistral 7B Instruct

大規模クラウドモデルより弱い面もありますが、制御権は完全にこちら側です。自分はローカルモデルで第1稿を出し、その後ホスティングモデルで仕上げることもあります。

- 厳しめのモデル + ヒューマナイザーの組み合わせ

ここは @mikeappsreviewer 氏と少し意見が違います。検出器スコアを「証拠」として頼るのは避けます。検出器は人間文にも AI 文にも誤判定が多いので、あくまで参考シグナル程度に見ています。

とはいえ Clever Ai Humanizer は別の理由で有用です。典型的な LLM のリズムを崩してくれます。慎重でフィルター強めのモデルから出た回答を通すと、ポリシー調のしゃべりより、普通の文章っぽい感じになることが多いです。「AI っぽくない」トーンにしたいときや、単純なフィルターに引っかかる確率を下げたいワークフローでは役立ちます。

自分が使う場面:

・堅苦しくなりがちな長文の解説記事

・「私は AI 言語モデルとして…」を繰り返すドラフト

・厳しめフロントエンドから出た有用情報だが、読み味がロボっぽいテキスト

- ブロックを減らすプロンプトの工夫

一部の聞き方はフィルターを即座にトリガーします。聞き方を変えるだけで、かなりの摩擦を避けられます。

有効だった例:

・センシティブな話題では、直接的なノウハウではなく「メリットとデメリット」「リスク分析」「ポリシーレビュー」「架空のシナリオ」として聞く

・「X のやり方を教えて」ではなく「評価を手伝って」のように頼む

・タスクを分解する。まず理論、次に比較、最後に自分の文体での書き換えを頼む、といった段階的アプローチ。多くのモデルは、ストレートな要求よりこのルートのほうを許容しがちです。

・安全系で壁に当たりやすい調査テーマは、「専門家が何を警告しているか説明して」「安全ガイドラインを要約して」といった形で聞く

- ガードレールが軽めのフロントエンド

依然として安全ですが、大手サイトほどうるさくないことが多いです。

・Perplexity 無料版

リサーチ向き。一部テーマには厳しいものの、「focus」モードや出典表示があるので、生の情報を引き出してから自分で書き換えたりヒューマナイズしたりしやすいです。自分は事実確認には Perplexity、トーン調整には Clever Ai Humanizer という組み合わせをよく使います。

・Poe の無料モデル

コミュニティボットの中には、特に古いモデルや小さいモデルでやや自由度高めのものがあります。日次の利用制限はありますが、ちょっとした用途なら十分です。

- 避けたほうがよいもの

・「完全脱獄」「フィルター完全無効」「検出器 100 パーセント回避」などをうたうツールで、中身が不透明なもの。多くは同じモデルへの薄いラッパーにすぎず、ログも怪しいことがあります。

・AI 検出器スコアへの盲信。あくまで簡易チェックにとどめ、人間が読んで自然か、内容が正確かを優先したほうがよいです。

自分が BypassGPT の代わりに使っているシンプルなワークフロー:

- まずは緩めのモデルでドラフトを書く。LM Studio 経由のローカルモデルか、OpenRouter 上のモデルを使う。

- 文章が硬すぎるときは、Clever Ai Humanizer を一度だけ通す。モードはだいたい Casual。

- 事実関係、抜けているケース、ぎこちない表現などを自分でざっと修正する。

- 投稿先が厳しいプラットフォームなら、「安全寄り」のモデルに依頼して、より中立的・学術的なトーンに言い換えてもらい、必要ならもう一度ヒューマナイズ。

これは昔の BypassGPT の挙動を完全に再現するものではありませんが、次のようなメリットは得られます。

・ローカルモデルやサードパーティモデル経由で、検閲度合いを自分でコントロールしやすい

・Clever Ai Humanizer のようなツールで、ロボットっぽさを軽減できる

・怪しい「脱獄サイト」にすべてを投げずに済み、自分の安全性も高められる

結論として、安全に使える「無料で検閲なしの BypassGPT 完全クローン」をそのまま手に入れることはできません。ですが、@mikeappsreviewer と @waldgeist が紹介していたものとは別の構成で、彼らの手法を丸ごと真似せずに、機能の大部分を再現することはできます。

自分にとってうまくいっているやり方は次の通りです。

- 「魔法の脱獄」系サイトは避ける

多くの BypassGPT 風サイトは、大手 API に薄いスキンを被せただけで、怪しいログ取得とプロンプトの小細工をしている程度でした。今も残っているものの多くはだいたい次のような感じです。

- 全てをログに残している

- 「検閲なし」を大げさに宣伝している

- 突然オフラインになる

安全性と安定性を重視するなら、こうしたサイトはやめておいた方がいいです。

- 「1 体の無制限ボット」ではなく、2 モデル構成にする

無法地帯の 1 モデルを探す代わりに、役割を分けています。

-

モデル A:「まじめな頭脳」

精度の高いモデル(大手プロバイダの無料枠や小さめのクラウドモデルなど)を使って、正確な情報・構成・推論を出させます。「それはできません」と言われることは受け入れます。 -

モデル B:「トーンと柔軟さ」

その出力を別ツールに渡し、事実ではなく文体だけを担当させます。ここで Clever Ai Humanizer のようなツールが真価を発揮します。

自分は @mikeappsreviewer ほど検出ツールのスコアを重視していませんが、使い道には同意しています。ロボット的な「AI らしい断り文句」っぽさをうまく消してくれるので、中身はほぼ同じでも「制限が少ない」感じの文章になります。

この 2 ステップ構成で、次のようなメリットがあります。

- 慎重なモデルから、よりクリーンで事実ベースの内容を得られる

- その上にヒューマナイザーレイヤーをかけて、読んだ印象は「フィルターなしの人間」っぽくなる

- Clever Ai Humanizer を「透明マント」としてではなく戦略的に使う

@ mikeappsreviewer と @waldgeist が一般的なツールとしての解説はしているので、そこは繰り返しません。自分が Clever Ai Humanizer を BypassGPT 代替として特に便利だと感じたのは次の点です。

-

部分的に検閲された回答を、実用レベルまで引き上げる

例:モデルが「手順の説明はできませんが、一般的なポイントとしては…」のような答えを出したとき、

それをヒューマナイザーに通すと、いちいち自分で書き直さなくても、ポリシー文ではなく普通のエッセイのように読める文章になります。 -

長い技術文書から「AI っぽさ」を抜く

ブログ記事・レポート・クライアント向け資料などのワークフローでは、本当に困るのは検閲そのものより「トースターが書いたみたいな文章」になってしまうことです。Clever Ai Humanizer は、特に Casual スタイルでこの問題をかなりうまく解消してくれます。

自分としては、「AI 検出ツールで 0% を目指す」方向には行きません。ここは二人と意見が分かれるところです。検出ツールの挙動はバラバラで、それに合わせて文章を最適化しようとすると生産性がどんどん落ちます。

- フィルターを避けるだけでなく、プロンプトの「意図」そのものを変える

表現の仕方については既に @waldgeist から多くのヒントが出ていますが、自分が少し違う角度でやっているのは次のようなフレームです。

- 「フレーム」で考える:

- 探索フレーム:「専門家がどう考えるかを順を追って説明して…」

- 批判フレーム:「その欠点・制約・失敗パターンを分析して…」

- 理論上の敵対フレーム:「誰かが X を悪用した場合に理論的には何が起こり得るか、そして本来システムはどう防ぐべきかを説明して」

自分を「実行者」ではなく「分析者」として位置づけると、モデルは比較的寛容になります。直接的な「やり方」アラートを踏まずに、かなり濃い情報を引き出せます。

- ローカルモデルは「付きっきり」を許容できる場合だけ

「そのまま BypassGPT を置き換える」という点では、自分は @waldgeist ほどローカルモデルに強気ではありません。

- 検閲が少ないのは確かです。

- ただし、よほどのハードウェアとチューニングの根気がない限り、細かく正確な多段推論ではクラウドの大規模モデルに劣ります。

- 幻覚も増えるので、重要な用途にはむしろ向きません。

自分はローカルモデルを「サンドボックス的なブレスト用」と割り切っています。フィクション・刺激的な台詞・極端な仮想シナリオなどには良いですが、「唯一の真実のソース」として使うのは避けています。

- 「検閲なし」に対する現実的な線引き

もしあなたの言う「検閲なし」が次のようなものなら:

- ダークユーモア

- NSFW 寄りのフィクション

- かなり辛口の意見

たいていは次のようなやり方で「ほぼ十分なレベル」まで持っていけます。

- フィクションとして描写させる

- 「小説 / 脚本のため」という目的をはっきり書く

- そのうえで Clever Ai Humanizer のようなツールに通して、リスクを気にしすぎる広報担当ではなく、普通の人間が話しているようなトーンに整える

一方で、「明らかに有害なことを実行するための、具体的で段階的な手順」を求めているなら、安全な無料ツールが BypassGPT の完全代わりになることはありません。壊れかけのサイトを渡り歩いて、どこかが消えるたびにまた探し直す、ということの繰り返しになります。

- 自分が実際に BypassGPT の代わりに使っている、シンプルな構成

凝った開発環境も追加ソフトも不要です。

- アイデア・構成・事実確認には、それなりに優秀だがやや慎重なモデルを使う。

- その出力をそのまま Clever Ai Humanizer にかけて、AI っぽさや不要な注意書きを削り、自然な文章にする。

- 最後に人間がざっと見直して、冗長な部分を削り、若干不自然な表現を修正する。

この結果として得られるものは:

- 以前「バイパス系フロントエンド」から得ていた柔軟性の 9 割くらい

- 「チャットボットが書いた」感のないコンテンツ

- ワークフローの途中に怪しい「脱獄サイト」を挟まずに済む安心感

昔の BypassGPT が絶好調だった日のような「暴れっぷり」には届きません。

ですが、安定していて、ほぼ無料で、安全に長期運用できるという意味では、こちらの方が実務ではずっと役に立ちます。