Früher habe ich auf BypassGPT für flexiblere KI‑Antworten gesetzt, aber es ist nicht mehr verfügbar und mein Workflow leidet darunter. Gibt es sichere, kostenlose Alternativen oder Tools, die ein ähnliches unzensiertes oder weniger eingeschränktes KI‑Verhalten bieten, ohne Regeln zu brechen oder Sperren zu riskieren? Über Empfehlungen würde ich mich sehr freuen, ebenso über Hinweise zur Einrichtung sowie Sicherheits‑ und Datenschutzaspekte, die ich kennen sollte.

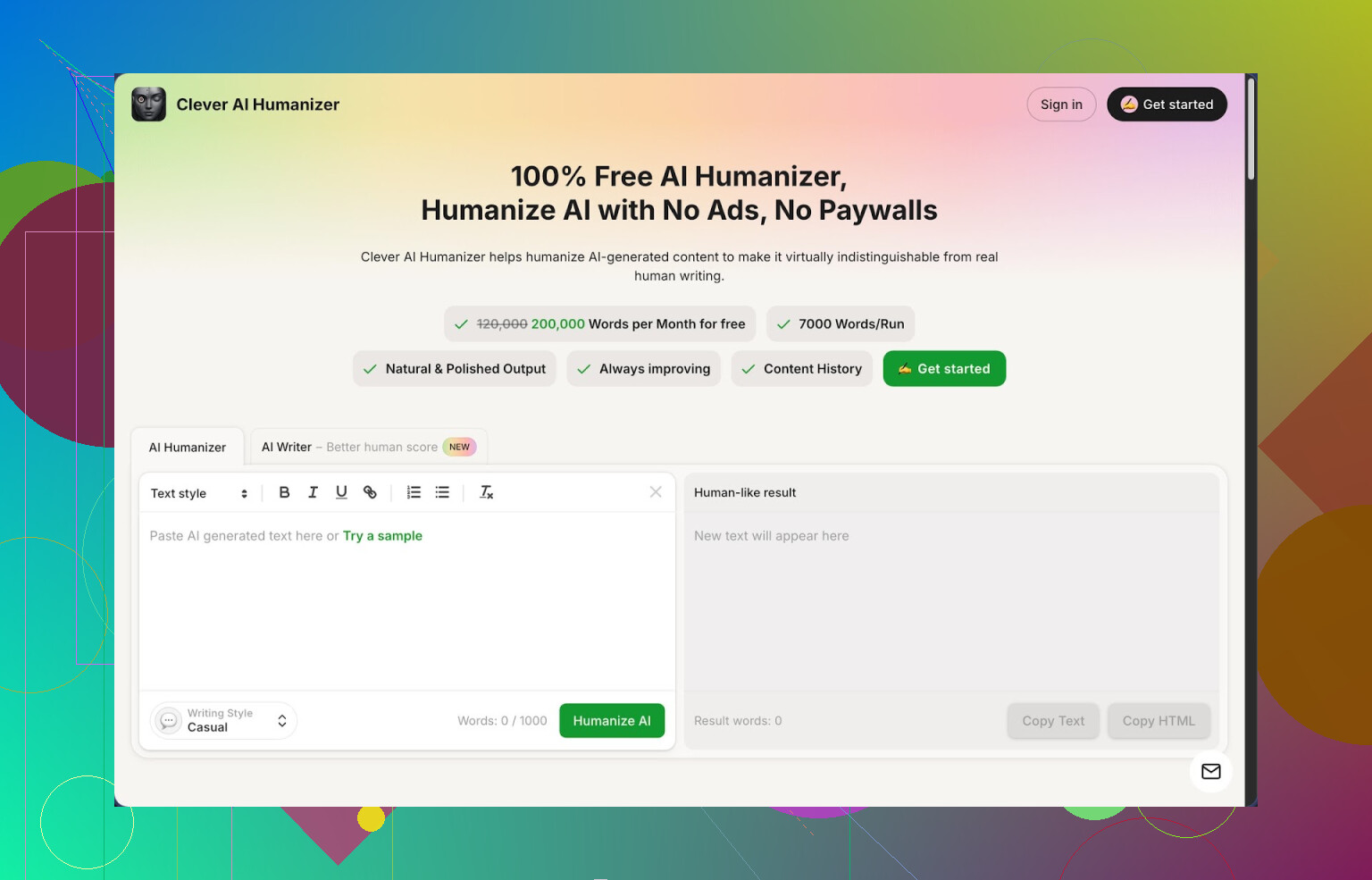

1. Clever AI Humanizer – mein Eindruck nach viel zu langer Spielerei damit

Clever AI Humanizer ist das Tool, zu dem ich immer wieder zurückkehre, wenn KI‑Text endlich nicht mehr nach KI klingen soll. Nicht weil es perfekt wäre, sondern weil die Limits großzügig sind und es mich nicht alle 3 Minuten nach Geld fragt.

Schnelle Zahlen aus meiner Nutzung:

- Etwa 200.000 Wörter pro Monat im Gratis‑Tarif

- Bis zu 7.000 Wörter pro Durchlauf

- Drei Stile: Locker, Einfache Wissenschaft, Einfache Formell

- Eingebauter KI‑Schreiber, Grammatikprüfer, Paraphrasier‑Tool

Ich bin zuerst darauf gestoßen, als ich längere Texte an ZeroGPT vorbeibekommen wollte. Ich habe ein paar tausend Wörter reinen Modell‑Output eingefügt, den Casual‑Modus drüberlaufen lassen, und ZeroGPT zeigte 0% KI bei drei verschiedenen Proben. Das hat mich beeindruckt, weil die meisten Tools entweder die Bedeutung kaputt machen oder trotzdem als „wahrscheinlich KI“ markiert werden.

Das große Problem, wenn man mit KI schreibt, ist bekannt: Alles klingt flach, wiederholend, und Detektoren markieren es als 100% Maschine. Ich habe an einem Wochenende eine ganze Reihe von „Humanizern“ getestet, und dieses hier war am Ende das einzige, das im Browser‑Tab offen geblieben ist.

So funktioniert das Hauptmodul aus meiner Sicht.

Du fügst deinen KI‑Text ein, wählst einen Stil (ich bleibe meist bei Locker), klickst auf den Button und wartest ein paar Sekunden. Dann bekommst du eine umformulierte Version zurück, die versucht, typische KI‑Muster aufzubrechen, Stellen zu kürzen oder zu verlängern und Formulierungen so zu verschieben, dass Detektoren es als natürlicher einstufen. Das höhere Limit hilft enorm bei langen Artikeln oder Berichten, weil das Zerstückeln in Mini‑Abschnitte den Fluss oft ruiniert.

Überraschend fand ich, dass die ursprüngliche Bedeutung in der Regel erhalten bleibt. Ich habe es mit technischen Anleitungen, Meinungsstücken und einem trockenen, akademisch angehauchten Abschnitt getestet. In den meisten Durchläufen blieben Kernaussagen und Daten gleich, während Struktur und Rhythmus so verändert wurden, dass es eher nach etwas klang, das eine Person an einem Nachmittag getippt hat.

Jetzt zu den Zusatzmodulen, denn die machen es im Alltag wirklich nützlich.

Der kostenlose KI‑Schreiber erlaubt dir, den ersten Entwurf direkt auf der Seite zu erzeugen. Du gibst ein Prompt für Artikel oder Aufsatz, er schreibt eine Basisversion, und anschließend jagst du diese in einem Rutsch durch den Humanizer. Bei den Detektor‑Werten war diese Kombi für mich am besten. Der rohe KI‑Entwurf wurde bei ZeroGPT oft als „stark KI‑basiert“ eingestuft, nach dem Humanisieren sank er in mehreren Tests auf 0%.

Der kostenlose Grammatikprüfer ist einfach, aber praktisch. Er beseitigt Dinge wie doppelte Leerzeichen, überflüssige Kommas und holprige Formulierungen. Nicht so aggressiv wie etwa Grammarly, aber ausreichend, um Texte ohne viel Zusatzaufwand blog‑ oder mailfertig zu machen.

Der kostenlose KI‑Paraphrasierer ist eher ein klassischer Umformulierer. Ich habe ihn genutzt für:

- Umformulieren von Absätzen aus älteren Artikeln

- Alternative Versionen für SEO‑Tests

- Anpassen des Tons von steif zu lockerer oder umgekehrt

Alles steckt in einer Oberfläche, daher sieht der Workflow bei mir so aus:

- Entwurf mit KI‑Schreiber oder Text aus einem anderen Modell einfügen

- Durch den Humanizer im Casual‑Stil laufen lassen

- Schneller Durchgang mit dem Grammatikprüfer

- Optionaler Paraphrasier‑Durchgang für einzelne Abschnitte

Dieses Setup hat mir viel Zeit gespart, wenn ich mehrere Varianten eines Artikels zum Testen brauchte oder wenn ich für einen Kunden, der den typischen LLM‑Ton hasst, etwas schnell „ent‑KI‑en“ musste.

Paar Nachteile aus meiner Nutzung:

- Nicht jeder Detektor zeigt jedes Mal 0% KI. ZeroGPT mochte die Ergebnisse in meinen Tests, aber andere Detektoren haben Teile manchmal weiterhin als gemischt oder teilweise KI‑basiert markiert.

- Texte werden nach dem Humanisieren oft länger. Es fügt Phrasen hinzu oder dehnt sie, um Muster zu brechen; wenn du also strenge Wortvorgaben hast, musst du manuell kürzen.

- Gelegentlich rutscht eine seltsame Formulierung durch, besonders bei technischen oder Nischenthemen. Ich lese dafür meistens einmal kurz gegen.

Trotzdem ist es für ein kostenloses Tool mit 200.000 Wörtern im Monat das praktischste, das ich benutzt habe. Keine Paywall mitten im Durchlauf, und man kann viel ausprobieren, bevor man an ein Limit stößt.

Wenn du mehr Details und Screenshots möchtest, gibt es hier eine längere Analyse:

https://cleverhumanizer.ai/community/t/clever-ai-humanizer-review-with-ai-detection-proof/42

Video‑Review hier, falls du lieber zusiehst, wie jemand sich durchklickt:

Clever AI Humanizer Youtube Review https://www.youtube.com/watch?v=G0ivTfXt_-Y

Auf Reddit gibt es außerdem Diskussionen über AI‑Humanizer und Tests von anderen Leuten:

Beste AI Humanizer auf Reddit https://www.reddit.com/r/DataRecoveryHelp/comments/1oqwdib/best_ai_humanizer/?tl=de

Alles über das Humanisieren von KI https://www.reddit.com/r/DataRecoveryHelp/comments/1l7aj60/humanize_ai?tl=de/

Kurzfassung. Es gibt kein sicheres, kostenloses Tool, das dir wirklich „ungefiltertes“ BypassGPT‑Verhalten ohne Nachteile liefert, aber du kannst mit einer Mischung aus Modellen und einem Humanizer in Sachen Flexibilität relativ nah herankommen.

Das hat für mich am besten funktioniert:

- Statt „Bypass“-Wrappern eher permissivere Modelle nutzen

Das ist kein Zaubertrick, aber sie haben weniger strenge Sicherheitsfilter als die meisten Chatbots.

• OpenRouter

Ermöglicht dir, viele Modelle über eine einzige Seite oder einen Key anzusprechen. Manche Modelle dort antworten freier als typische Frontends. Du steuerst Temperatur und System-Prompts, was dir bereits „weniger eingeschränkte“ Antworten für Brainstorming, Fiktion, edgy Inhalte usw. gibt.

Nachteil. Öffentliche Modelle protokollieren Anfragen, also keine sensiblen Daten senden.

• Lokale Modelle mit Ollama oder LM Studio

Modelle auf deinem eigenen PC ausführen. Keine Remote-Filter.

Gute kostenlose Einstiege:

- Llama 3 8B Instruct

- Qwen 2.5 7B oder 14B

- Mistral 7B Instruct

Sie sind bei manchen Aufgaben schwächer als große Cloud-Modelle, aber du hast die volle Kontrolle. Für einige Workflows lasse ich einen ersten Durchgang von einem lokalen Modell machen und verfeinere dann mit einem gehosteten.

- Strengere Modelle mit einem Humanizer kombinieren

Hier bin ich teilweise anderer Meinung als @mikeappsreviewer. Ich würde mich nicht auf Detector-Scores als eine Art „Beweis“ verlassen. Detectoren liegen oft sowohl bei menschlichem als auch bei KI-Text daneben. Ich sehe sie nur als grobes Signal, nicht als Zielgröße.

Trotzdem ist Clever Ai Humanizer aus einem anderen Grund nützlich. Er durchbricht den typischen LLM-Rhythmus. Wenn du eine vorsichtige oder gefilterte Antwort eines zurückhaltenden Modells hindurchschickst, wirkt der Output oft weniger wie Policy-Sprech und mehr wie normales Schreiben. Für Workflows, die einen „nicht nach KI klingenden“ Ton oder eine geringere Chance brauchen, von einfachen Filtern geflaggt zu werden, hilft das.

Ich nutze ihn für:

• Lange Erklärtexte, die steif klingen.

• Entwürfe, in denen das Modell ständig „als KI-Sprachmodell“ wiederholt.

• Texte aus strengeren Frontends, die inhaltlich gut sind, aber roboterhaft klingen.

- Prompt-Taktiken, die Hürden reduzieren

Manche Prompts lösen Filter sehr schnell aus. Du kannst viel Reibung vermeiden, indem du die Fragestellung änderst.

Beispiele, die mir geholfen haben:

• Statt direkter How‑to-Sprache zu heiklen Themen nach „Vor- und Nachteilen“, „Risikobewertung“, „Policy-Review“ oder einem „fiktiven Szenario“ fragen.

• „Hilf mir zu bewerten“ statt „sag mir, wie man X macht“.

• Aufgaben in Schritte aufteilen. Erst nach Theorie fragen, dann nach Vergleich, dann nach Umschreiben in deinem Ton. Viele Modelle tolerieren diesen Weg besser als direkte Bitten.

• Bei Forschungsthemen, die auf Sicherheitsbarrieren stoßen, Formulierungen wie „erkläre, wovor Fachleute warnen“ oder „fass Sicherheitsrichtlinien zusammen“ verwenden.

- Frontends mit leichteren Guardrails

Sie sind immer noch sicher, aber in der Regel weniger belehrend als Mainstream-Seiten.

• Perplexity Free-Tier

Gut für Recherche. Bei manchen Themen strenger, aber seine „Focus“-Modi und Zitate helfen dir, Rohinformationen zu ziehen, die du dann umschreibst oder humanizest. Ich nutze oft Perplexity für Fakten und Clever Ai Humanizer für den Ton.

• Poe kostenlose Modelle

Einige Community-Bots antworten freier, besonders ältere oder kleinere Modelle. Es gibt ein Tageslimit, aber für schnelle Aufgaben reicht es.

- Was ich vermeiden würde

• Tools, die „vollständigen Jailbreak“, „gar keine Filter“ oder „100 Prozent Detector-Bypass“ ohne Transparenz versprechen. Oft sind das nur dünne Hüllen um dieselben Modelle, plus fragwürdiges Logging.

• Blindes Vertrauen in AI-Detector-Scores. Nutze sie nur als schnellen Check. Fokus zuerst auf Lesbarkeit für Menschen und inhaltliche Richtigkeit.

Ein einfacher Workflow, der BypassGPT für mich ersetzt hat:

- Entwurf mit einem permissiveren Modell. Entweder ein lokales Modell über LM Studio oder ein Modell auf OpenRouter.

- Wenn der Ton zu steif ist, einmal durch Clever Ai Humanizer schicken, meistens Casual.

- Kurzer manueller Check für Fakten, Spezialfälle und holprige Formulierungen.

- Wenn eine Plattform streng ist, ein „vorsichtigeres“ Modell bitten, den Text in neutralerem oder akademischem Ton umzuformulieren, dann bei Bedarf erneut humanizen.

Das reproduziert das alte BypassGPT-Verhalten nicht vollständig, aber du bekommst:

• Mehr Kontrolle über Zensur durch lokale oder Drittanbieter-Modelle.

• Weniger roboterhafte Ausgaben durch ein Tool wie Clever Ai Humanizer.

• Mehr Sicherheit für dich selbst, weil du nicht alles in irgendwelche dubiosen Jailbreak-Seiten einspeist.

Kurzfassung: Du wirst kein 1:1 „kostenloses, unzensiertes BypassGPT‑Klon“-Setup bekommen, das wirklich sicher ist. Aber du kannst den größten Teil dieser Funktionalität mit einem anderen Stack nachbauen als dem, den @mikeappsreviewer und @waldgeist beschrieben haben, ohne ihr gesamtes Playbook zu kopieren.

So läuft es bei mir gut:

- Lass die „magischen Jailbreak“-Seiten weg

Die meisten BypassGPT‑ähnlichen Seiten waren nur dünne Hüllen über denselben Mainstream‑APIs, mit dubiosem Logging und etwas Prompt‑Trickserei. Die, die noch existieren, machen meist:

- Vollständiges Logging

- Übertriebene „unzensiert“-Versprechen

- Zufällige Ausfälle

Wenn dir Sicherheit und Verlässlichkeit wichtig sind, sind die ein No‑Go.

- Nutze Workflows mit zwei Modellen statt „einem unzensierten Bot“

Statt ein einziges Wildwest‑Modell zu jagen, teile ich die Aufgabe auf:

-

Modell A: „Seriöses Gehirn“

Nutze ein solides Modell (z. B. die kostenlose Stufe eines großen Anbieters oder ein kleineres Cloud‑Modell) für korrekte Infos, Struktur und Reasoning. Du akzeptierst, dass es manchmal sagt „Das kann ich nicht tun“. -

Modell B: „Ton + Flexibilität“

Dann fütterst du das Ergebnis in ein separates Tool, dessen einzige Aufgabe Stil ist, nicht Fakten. Hier glänzt Clever Ai Humanizer tatsächlich.

Ich sehe die starke Fixierung von @mikeappsreviewer auf Detektor‑Scores etwas kritischer, aber beim Use Case stimme ich zu: Das Tool ist sehr gut darin, diese roboterhafte „AI‑Disclaimer“-Stimme rauszunehmen, was sich „weniger eingeschränkt“ anfühlt, obwohl der Inhalt im Kern derselbe bleibt.

Dieser zweistufige Aufbau bringt dir:

- Sauberere, faktenorientierte Inhalte von einem vorsichtigen Modell

- Output, der sich dank Humanizer‑Schicht wie ein ungefilterter Mensch liest

- Nutze Clever Ai Humanizer strategisch, nicht als magischen Tarnumhang

Sowohl @mikeappsreviewer als auch @waldgeist haben es schon als generelles Tool erklärt, das wiederhole ich nicht im Detail. Wofür Clever Ai Humanizer für einen BypassGPT‑Ersatz besonders nützlich ist:

-

Teilzensierte Antworten brauchbar machen

Beispiel: Das Modell sagt „Ich kann keine Schritt‑für‑Schritt‑Anleitung geben, aber hier sind allgemeine Hinweise …“

Du jagst das durch den Humanizer und plötzlich wirkt es wie ein normaler Aufsatz statt wie eine Richtlinien‑Ansage, ohne dass du alles von Hand umschreiben musst. -

Längere technische Texte ent‑AI‑en

Wenn du Blogposts, Reports, Kundendokus usw. erstellst, ist das echte Problem oft nicht Zensur, sondern „klingt wie von einem Toaster geschrieben“. Clever Ai Humanizer behebt genau das sehr gut, vor allem im Casual‑Stil.

Ich würde mir nicht 0 % AI‑Detektor‑Score als Ziel setzen. Da unterscheide ich mich von beiden. Detektoren sind extrem inkonsistent, und Texte um sie herum zu optimieren ist ein Rabbit Hole, das Produktivität killt.

- Ändere die Intention deiner Prompts statt nur Filter zu umschiffen

Du hast von @waldgeist schon viele Formulierungs‑Tipps bekommen. Ein etwas anderer Blickwinkel, den ich nutze:

- Denk in „Frames“:

- Explorations‑Frame: „erkläre, wie Expertinnen und Experten über … nachdenken“

- Kritik‑Frame: „analysiere Schwächen, Grenzen, Fehlermodi von …“

- Adversarial‑Frame, aber theoretisch: „beschreibe, was schiefgehen könnte, wenn jemand X missbraucht, und wie Systeme das eigentlich verhindern sollen“

Modelle sind toleranter, wenn du dich als Analyst präsentierst, nicht als Ausführender. Du bekommst weiterhin viele Details, ohne die härtesten „How‑to“-Filter auszulösen.

- Lokale Modelle nur, wenn du sie babysitten willst

Ich bin für einen „Drop‑in‑Ersatz“ für BypassGPT bei lokalen Modellen skeptischer als @waldgeist:

- Ja, du hast weniger Zensur.

- Nein, sie sind bei feinem, faktenreichem, mehrstufigem Denken nicht so gut wie große Cloud‑Modelle, außer du hast starke Hardware und viel Tuning‑Geduld.

- Sie halluzinieren auch öfter, was den Zweck konterkariert, wenn dir die Aufgabe wirklich wichtig ist.

Ich nutze lokale Modelle als „Sandbox‑Brainstorming‑Tools“, nicht als Kern eines professionellen Workflows. Gut für Fiction, edgy Dialoge, wilde Was‑wäre‑wenn‑Ideen. Nicht ideal als einzige Wahrheitsquelle.

- Realitätscheck „unzensiert“

Wenn „unzensiert“ für dich heißt:

-

Schwarzer Humor

-

Etwas NSFW‑Fiction

-

Würzige Meinungen

kommst du meist nah genug ran mit: -

Umstellung auf fiktive Szenarien

-

Explizit sagen „das ist für einen Roman / ein Drehbuch“

-

Dann das Ergebnis mit Clever Ai Humanizer so glätten, dass es nach echter Person klingt, nicht nach risikoscheuem PR‑Praktikanten.

Wenn du meinst „ich will exakte, operative Schritt‑für‑Schritt‑Anleitungen für offensichtlich schädliche Dinge“, wird dir kein sicheres kostenloses Tool als sauberer BypassGPT‑Ersatz dienen. Du springst nur zwischen halbkaputten Websites hin und her, bis eine verschwindet und die Suche von vorne beginnt.

- Eine schlanke Version des Stacks, der BypassGPT für mich ersetzt hat

Kein spezielles Dev‑Setup, keine Extra‑Software:

- Nutze ein ausreichend fähiges, eher vorsichtiges Modell für Ideen, Struktur und Fakten.

- Schicke dessen Output direkt durch Clever Ai Humanizer, um den AI‑Ton zu entfernen, nervige Disclaimer zu streichen und natürlichere Sprache zu bekommen.

- Mach einen kurzen menschlichen Feinschliff, um Wortballast zu kappen und kleine Sprachauffälligkeiten zu korrigieren.

Ergebnis:

- Rund 90 % der Flexibilität, die ich früher aus „Bypass“-Frontends bekommen habe

- Inhalte, die nicht „von einem Chatbot geschrieben“ schreien

- Keine dubiosen „Jailbreak“-Seiten mehr irgendwo mitten im Workflow

Ist es so wild wie das alte BypassGPT an einem guten Tag? Nein.

Ist es stabil, weitgehend kostenlos und sicher genug, um sich langfristig darauf zu verlassen? Ja – und für einen dauerhaften Workflow ist das wichtiger.